最近 OpenAI ChatGPT 的漏洞,让不少人可以看到他人的聊天标题,引发了用户的焦虑,在 AIGC、大模型时代,如果安全做不到保证,如何能让人放心的使用?

近日,微软为解决安全的后顾之忧,推出了一款名为 Microsoft Security Copilot 的全新生成式 AI 安全助手,旨在帮助安全技术专家更快地识别漏洞和免受黑客攻击。

据悉,Microsoft Security Copilot 将 GPT-4 的强大功能与微软的安全特定模型相结合。它的界面就是如下图所示的一个简单的提示输入框:

这款工具使用方式和 ChatGPT 有些类似,支持自然语言输入。当你问它安全问题时,Security Copilot 会使用 LLM 和特定于安全的模型来部署技能和查询,可以帮助安全员更快、更准确地检测和响应安全威胁。事实上,在这款工具的背后,由微软的全球威胁情报系统提供支持,微软声称该系统每天解析超过 65 万亿个信号。

借助 Microsoft Security Copilot,安全防御者可以在几分钟内对事件快速做出响应,并通过基于自然语言的调查获得关键的分步指导,捕捉平时无法检测到的内容,并实时就能获得任何过程或事件的摘要。

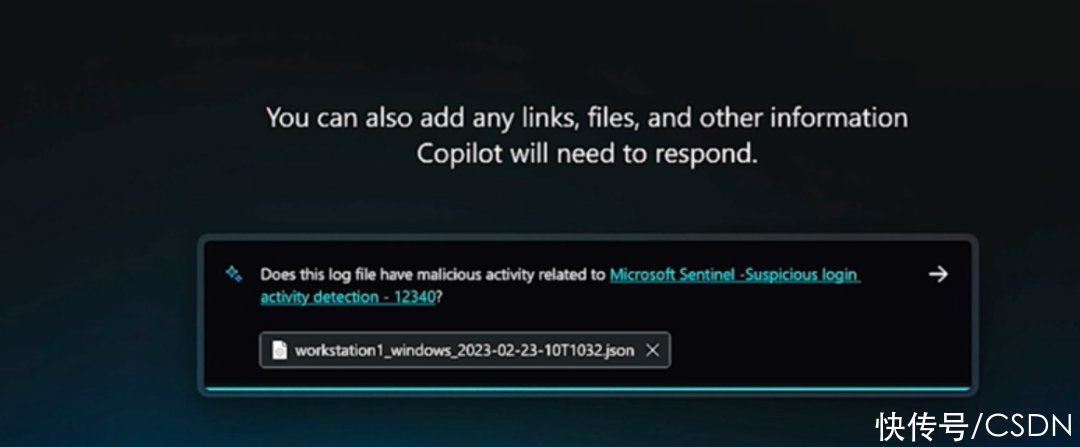

与此同时,安全技术人员可以利用提示词向 Security Copilot 询问有关漏洞、企业安全事件的介绍,也能输入文件、URL 或者代码片段让 Security Copilot 帮助分析,最终结果可以固定并汇总到一个共享的工作区中,这样不同的研究人员也可以进行相同的安全威胁事件分析和调查。

微软表示,与大多数 AI 模型一样,它不会总是完美地执行,并且可能会出错。不过,Security Copilot 在一个闭环学习系统中工作,该系统包括一个内置工具,供用户直接提供反馈。虽然在发布时它将整合微软的安全产品,但微软声称随着时间的推移它也将“扩展到不断壮大的第三方产品生态系统中”。

此外,微软也向用户保证,优先考虑用户的数据隐私问题,他们的数据不会被用来训练或丰富其他人工智能模型,并将受到未指定的企业合规控制的保护。

目前,Security Copilot 仅面向“少数用户”开放了预览,微软表示,「我们还没有讨论它全面面世的时间。我们认为重要的是将它提供给一小群人并开始迭代与反馈,并使其成为最好的产品最终确保我们能够负责任地交付它。」

对于这款工具感兴趣的安全研究人员也可以通过微软上线的官网一探究竟了:https://www.microsoft.com/en-us/security/business/ai-machine-learning/microsoft-security-copilot