一方面 AI 改变了人们工作和生活的方式,大大提高了效率;另一方面 AI 的运行和发展又充满不确定性,触发了人类对于未知事物的天然保护机制——恐惧。

一方面 AI 改变了人们工作和生活的方式,大大提高了效率;另一方面 AI 的运行和发展又充满不确定性,触发了人类对于未知事物的天然保护机制——恐惧。 今天,网络上一封公开的联名信爆火,该信呼吁所有的 AI 实验立即暂停研究比 GPT-4 更先进的 AI 模型,暂停时间至少 6 个月,为的就是把这些可怕的幻想扼杀在摇篮之中。AI 的进步速度实在过于惊人,但相关的监管、审计手段却迟迟没有跟上,这也意味着没有人能够保证 AI 工具以及使用 AI 工具的过程中的安全性。

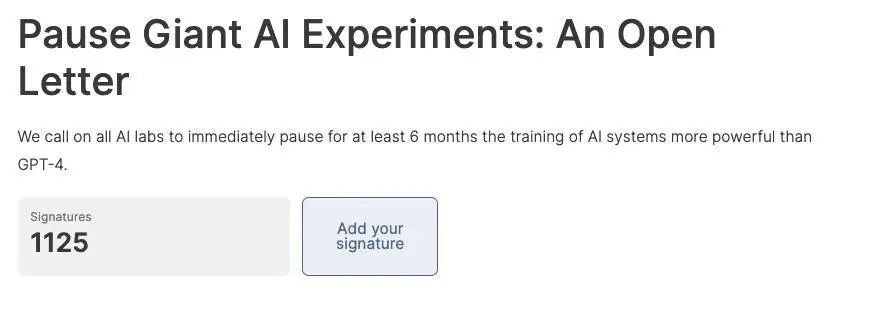

今天,网络上一封公开的联名信爆火,该信呼吁所有的 AI 实验立即暂停研究比 GPT-4 更先进的 AI 模型,暂停时间至少 6 个月,为的就是把这些可怕的幻想扼杀在摇篮之中。AI 的进步速度实在过于惊人,但相关的监管、审计手段却迟迟没有跟上,这也意味着没有人能够保证 AI 工具以及使用 AI 工具的过程中的安全性。 该联名信已经获得了包括 2018 年图灵奖得主 Yoshua Bengio、马斯克、史蒂夫 · 沃兹尼亚克、Skype 联合创始人、Pinterest 联合创始人、Stability AI CEO 等多位知名人士的签名支持,截稿前联名人数已经达到 1125 人。附上本封联名信的地址,感兴趣的朋友也可以去签上自己的名字。????????https://futureoflife.org/open-letter/pause-giant-ai-experiments/?continueFlag=d19c796896f3776241c518f8747afa68公开信的原文如下:人工智能具有与人类竞争的智能,这可能给社会和人类带来深刻的风险,这已经通过大量研究 [1] 得到证实,并得到了顶级 AI 实验室的认可 [2]。正如广泛认可的阿西洛马尔人工智能原则(Asilomar AI Principles)所指出的,先进的 AI 可能代表地球生命历史上的重大变革,因此应该以相应的关注和资源进行规划和管理。不幸的是,即使在最近几个月, AI 实验室在开发和部署越来越强大的数字化思维方面陷入了失控的竞争,而没有人能够理解、预测或可靠地控制这些数字化思维,即使是它们的创造者也无法做到这一点。现代 AI 系统现在已经在通用任务方面具有与人类竞争的能力 [3],我们必须问自己:

该联名信已经获得了包括 2018 年图灵奖得主 Yoshua Bengio、马斯克、史蒂夫 · 沃兹尼亚克、Skype 联合创始人、Pinterest 联合创始人、Stability AI CEO 等多位知名人士的签名支持,截稿前联名人数已经达到 1125 人。附上本封联名信的地址,感兴趣的朋友也可以去签上自己的名字。????????https://futureoflife.org/open-letter/pause-giant-ai-experiments/?continueFlag=d19c796896f3776241c518f8747afa68公开信的原文如下:人工智能具有与人类竞争的智能,这可能给社会和人类带来深刻的风险,这已经通过大量研究 [1] 得到证实,并得到了顶级 AI 实验室的认可 [2]。正如广泛认可的阿西洛马尔人工智能原则(Asilomar AI Principles)所指出的,先进的 AI 可能代表地球生命历史上的重大变革,因此应该以相应的关注和资源进行规划和管理。不幸的是,即使在最近几个月, AI 实验室在开发和部署越来越强大的数字化思维方面陷入了失控的竞争,而没有人能够理解、预测或可靠地控制这些数字化思维,即使是它们的创造者也无法做到这一点。现代 AI 系统现在已经在通用任务方面具有与人类竞争的能力 [3],我们必须问自己:我们应该让机器充斥我们的信息渠道,传播宣传和谎言吗?

我们应该将所有工作都自动化,包括那些令人满足的工作吗?

我们应该发展可能最终超过、取代我们的非人类思维吗?

我们应该冒失控文明的风险吗?

这些决策不应该由非选举产生的科技领导人来负责。只有当我们确信AI系统的影响是积极的,风险是可控的,我们才应该开发强大的AI系统。这种信心必须得到充分的理由,并随着系统潜在影响的增大而增强。OpenAI 最近关于人工智能的声明指出:「在某个时候,可能需要在开始训练未来系统之前获得独立审查,对于最先进的努力,需要同意限制用于创建新模型的计算增长速度。」我们同意。现在就是那个时刻。因此,我们呼吁所有 AI 实验室立即暂停至少 6 个月的时间,不要训练比 GPT-4 更强大的 AI 系统。这个暂停应该是公开和可验证的,并包括所有关键参与者。如果无法迅速实施这样的暂停,政府应该介入并实行一个暂禁令。AI 实验室和独立专家应该利用这个暂停时间共同制定和实施一套共享的先进 AI 设计和开发安全协议,这些协议应该由独立的外部专家严格审核和监督。这些协议应确保遵守它们的系统在合理怀疑范围之外是安全的 [4]。这并不意味着暂停 AI 发展,而只是从不断迈向更大、不可预测的黑箱模型及其突现能力的危险竞赛中退一步。AI 研究和开发应该重点放在提高现有强大、先进系统的准确性、安全性、可解释性、透明度、鲁棒性、对齐、可信度和忠诚度。与此同时,AI 开发者必须与政策制定者合作,大力加速 AI 治理体系的发展。这些至少应包括:专门负责 AI 的新的、有能力的监管机构;

对高能力 AI 系统和大型计算能力池的监督和跟踪;

用于区分真实与合成内容、跟踪模型泄漏的溯源和水印系统;

健全的审计和认证生态系统;对 AI 造成的损害承担责任;

技术AI安全研究的充足公共资金;

应对 AI 引起的巨大经济和政治变革(特别是对民主制度的影响)的资深机构。

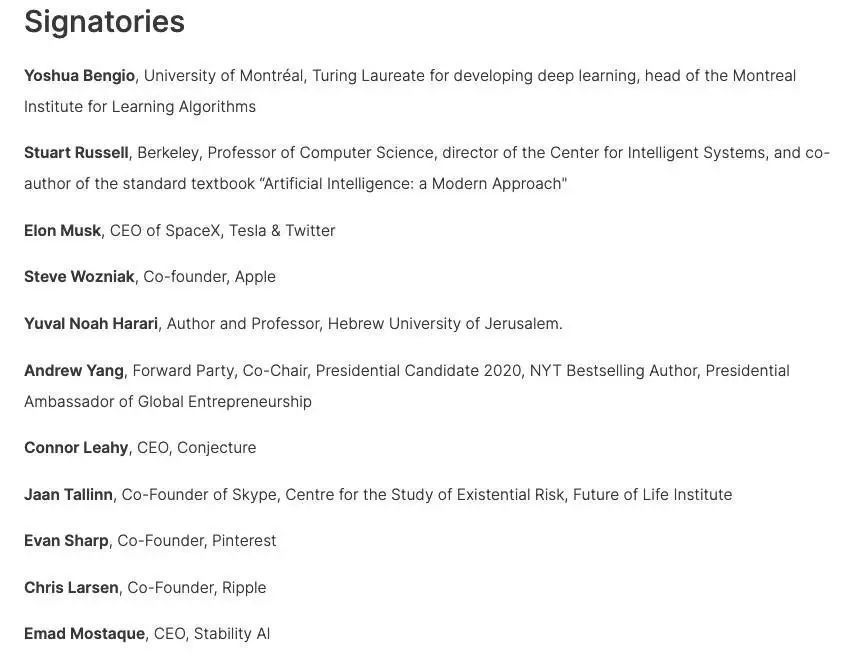

人类可以在 AI 的帮助下享受繁荣的未来。在成功创造出强大的 AI 系统之后,我们现在可以享受一个「AI 盛夏」,在其中我们收获回报,将这些系统明确地用于造福所有人,并让社会有机会适应。在面临可能对社会造成灾难性影响的其他技术上,社会已经按下了暂停键 [5]。在这里,我们也可以这样做。让我们享受一个漫长的 AI 盛夏,而不是毫无准备地冲向秋天。参考信息:[1]Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021, March). On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?????. In Proceedings of the 2021 ACM conference on fairness, accountability, and transparency (pp. 610-623).Bostrom, N. (2016). Superintelligence. Oxford University Press.Bucknall, B. S., & Dori-Hacohen, S. (2022, July). Current and near-term AI as a potential existential risk factor. In Proceedings of the 2022 AAAI/ACM Conference on AI, Ethics, and Society (pp. 119-129).Carlsmith, J. (2022). Is Power-Seeking AI an Existential Risk?. arXiv preprint arXiv:2206.13353.Christian, B. (2020). The Alignment Problem: Machine Learning and human values. Norton & Company.Cohen, M. et al. (2022). Advanced Artificial Agents Intervene in the Provision of Reward. AI Magazine, 43(3) (pp. 282-293).Eloundou, T., et al. (2023). GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models.Hendrycks, D., & Mazeika, M. (2022). X-risk Analysis for AI Research. arXiv preprint arXiv:2206.05862.Ngo, R. (2022). The alignment problem from a deep learning perspective. arXiv preprint arXiv:2209.00626.Russell, S. (2019). Human Compatible: Artificial Intelligence and the Problem of Control. Viking.Tegmark, M. (2017). Life 3.0: Being Human in the Age of Artificial Intelligence. Knopf.Weidinger, L. et al (2021). Ethical and social risks of harm from language models. arXiv preprint arXiv:2112.04359.[2]Ordonez, V. et al. (2023, March 16). OpenAI CEO Sam Altman says AI will reshape society, acknowledges risks: 'A little bit scared of this'. ABC News.Perrigo, B. (2023, January 12). DeepMind CEO Demis Hassabis Urges Caution on AI. Time.[3]Bubeck, S. et al. (2023). Sparks of Artificial General Intelligence: Early experiments with GPT-4. arXiv:2303.12712.OpenAI (2023). GPT-4 Technical Report. arXiv:2303.08774.[4]Ample legal precedent exists – for example, the widely adopted OECD AI Principles require that AI systems "function appropriately and do not pose unreasonable safety risk"[5]Examples include human cloning, human germline modification, gain-of-function research, and eugenics. 在这份公开信里,附上的签名表或许要比信的内容本身要精彩,你可以在这里找到很多熟悉的名字,每一个签名都表达了签名者对于 AI 的强烈怀疑态度。不过,有网友发现这些签名也不一定完全可信,因为在列表中出现了 OpenAI CEO Sam Altman(我封我自己?)和电影《疾速追杀》男主角 John Wick 的名字,具体的真实性还有待考究。

在这份公开信里,附上的签名表或许要比信的内容本身要精彩,你可以在这里找到很多熟悉的名字,每一个签名都表达了签名者对于 AI 的强烈怀疑态度。不过,有网友发现这些签名也不一定完全可信,因为在列表中出现了 OpenAI CEO Sam Altman(我封我自己?)和电影《疾速追杀》男主角 John Wick 的名字,具体的真实性还有待考究。

点击「在看」

是对我们最大的鼓励