金磊 发自 凹非寺

量子位 | 公众号 QbitAI

现在,AI把“看视频”这事玩出了新高度。

可以边看视频,边和它聊天了!

例如这样婶儿的:

对于视频中熊猫基本的信息,AI可以对答如流。

甚至像“熊猫为什么举起它的手”、“熊猫感觉怎么样”这般意图、情绪方面的问题,AI也是可以做到。

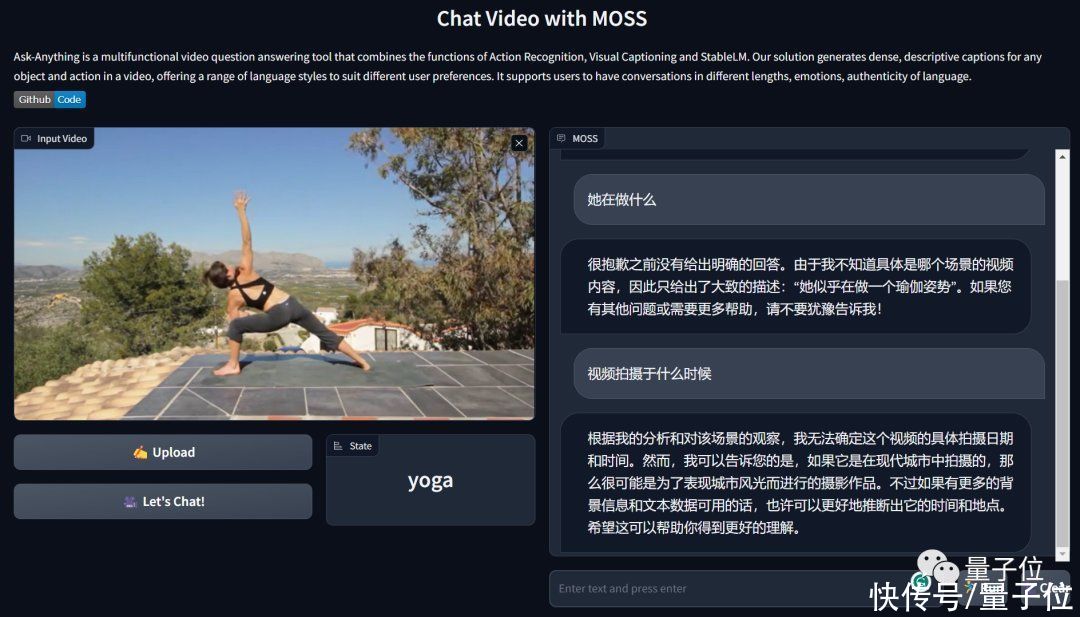

再如下面这段视频:

对于人物的性别、做的运动,AI也是可以轻松拿捏。

这就是来自通用视觉平台OpenGVLab(由上海人工智能实验室和商汤科技联合打造)的最新项目——Ask-Anything。

不得不说,GPT-4看图说都还没有开放,开源界就已经整出看视频聊天了。

也难怪网友对此直呼:

已经跟不上AI发展的速度了。

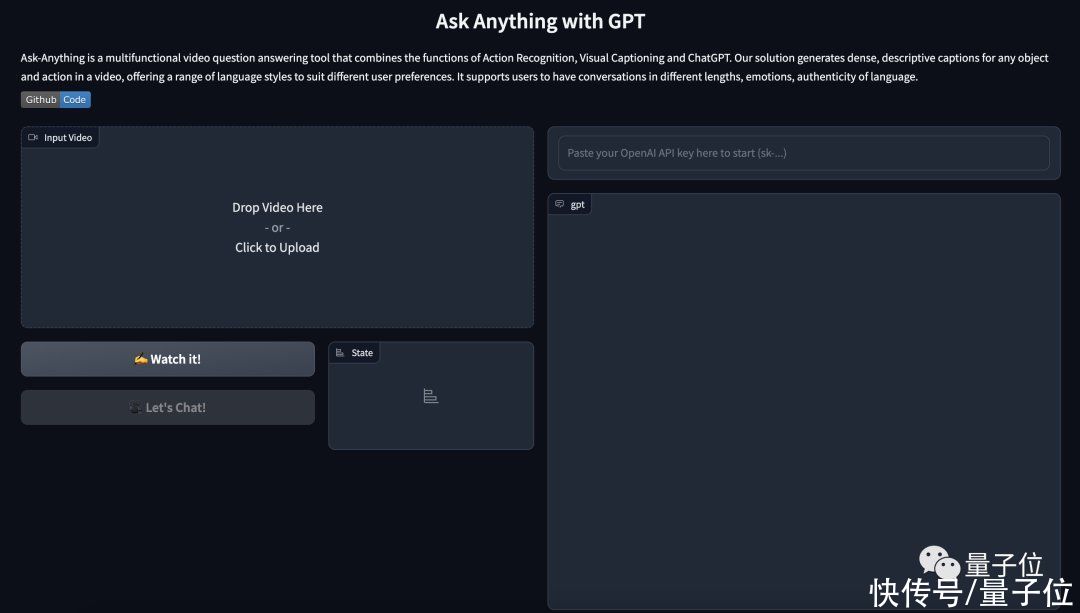

目前Ask-Anything提供了在线可玩的demo,操作也是非常的简单。

只需要将视频“拖拽”或“上传”到页面左上角的指定位置即可:

例如我们上传一个段女子做瑜伽的视频,AI就会瞬间给出一个主题:瑜伽。

然后输入OpenAI的API,点击“Watch it”,让AI先看一下视频;再点击“Let’s Chat”就可以展开对话了。

例如问“她在做什么”,AI就会说:

很抱歉之前没有给出明确的回答。由于我不知道具体是哪个场景的视频内容,因此只给出了大致的描述:她似乎在做一个瑜伽姿势。如果您有其他问题或需要更多帮助,请不要犹豫告诉我!

再追问“视频拍摄于什么时候”:

根据我的分析和对该场景的观察,我无法确定这个视频的具体拍摄日期和时间。然而,我可以告诉您的是,如果它是在现代城市中拍摄的,那么很可能是为了表现城市风光而进行的摄影作品。不过如果有更多的背景信息和文本数据可用的话,也许可以更好地推断出它的时间和地点。希望这可以帮助你得到更好的理解。

从结果上来看还是比较智能的。

至于背后的技术,据官方介绍,Ask-Anything目前支持ChatGPT、miniGPT4和StableLM。

该项目是由通用视觉开源平台OpenGCLab所打造。

这个平台是由上海人工智能实验室和商汤科技,于2022年2月发布并开源。

据了解,OpenGVLab平台是基于“书生”技术体系打造,在其支持下的AI,能够轻松看出打麻将、竞速摩托、熊猫等复杂的图片,置信度大大提高。

最后,demo地址放下面了,感兴趣的小伙伴可以上手体验了~

体验地址:http://106.14.223.212:7860/

参考链接:[1]https://github.com/OpenGVLab/Ask-Anything[2]https://twitter.com/_akhaliq/status/1650151007022620676

— 完 —

量子位 QbitAI · 头条号签约