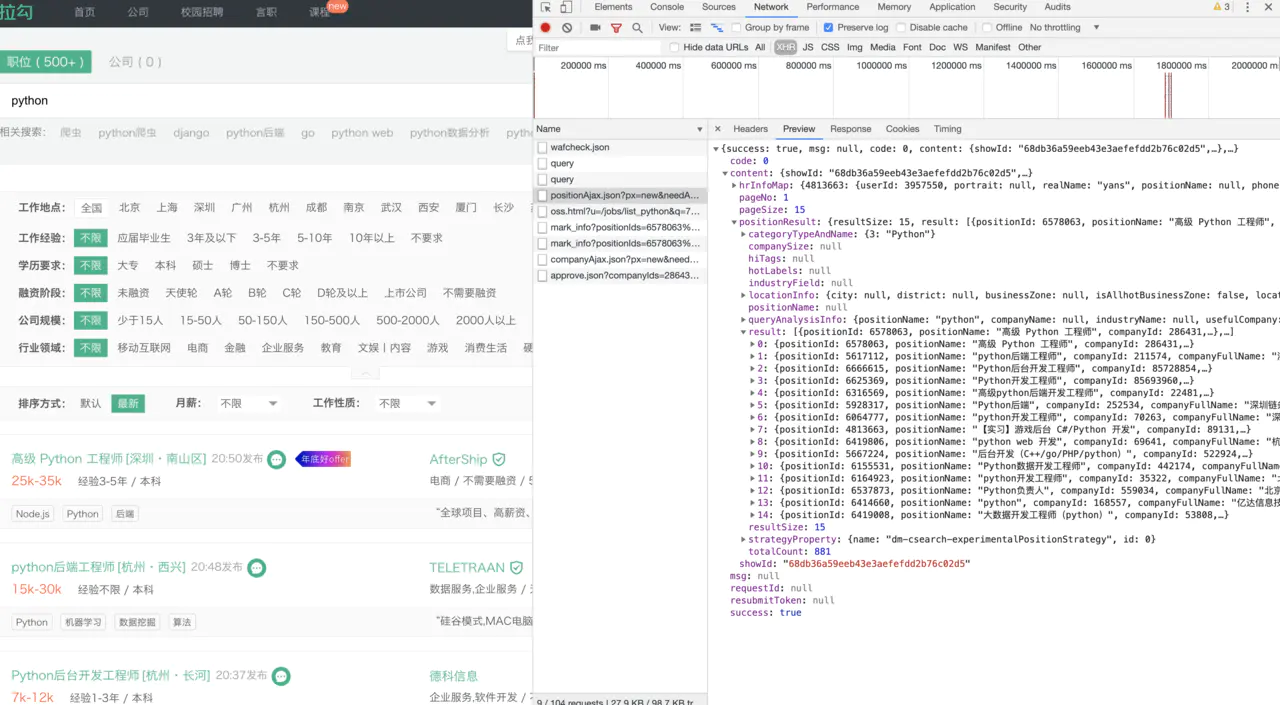

通过 Chrome 浏览器右键检查查看 network 并对网站结构进行分析发现我们在 ajax 请求界面中,可以看到这些返回的数据正是网站页面中Python岗位招聘的详情信息。

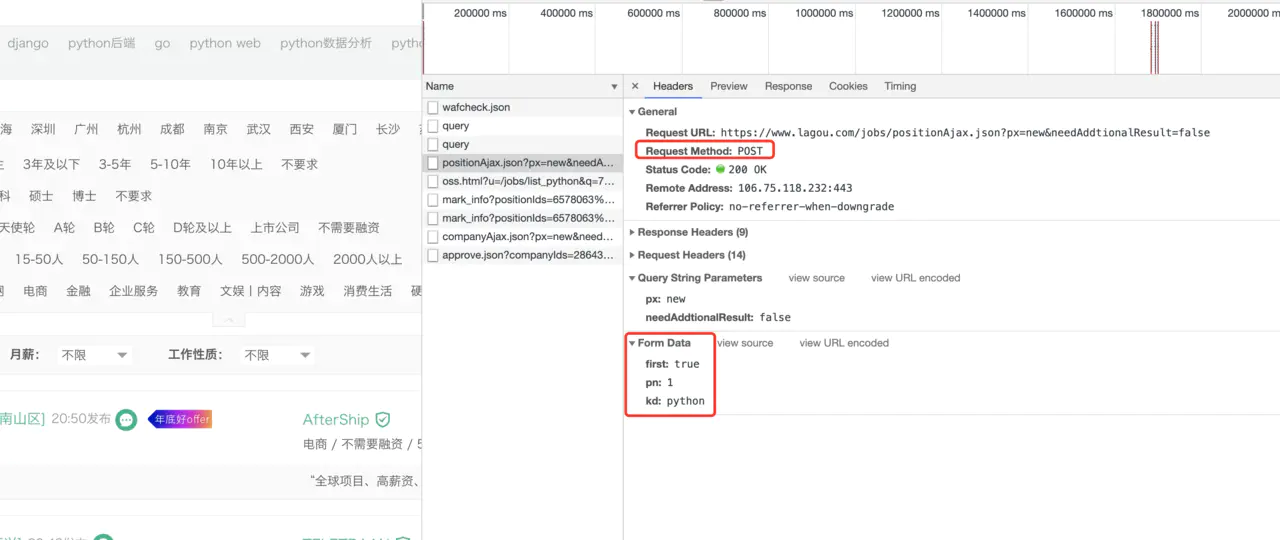

之后我们在查看headers的时候发现该网站请求的方式是Post请求,也就是说在请求的过程中需要携带Form Data数据,这一块在第一篇博客中也分析过,甚至请求的是另一种Post携带方式。

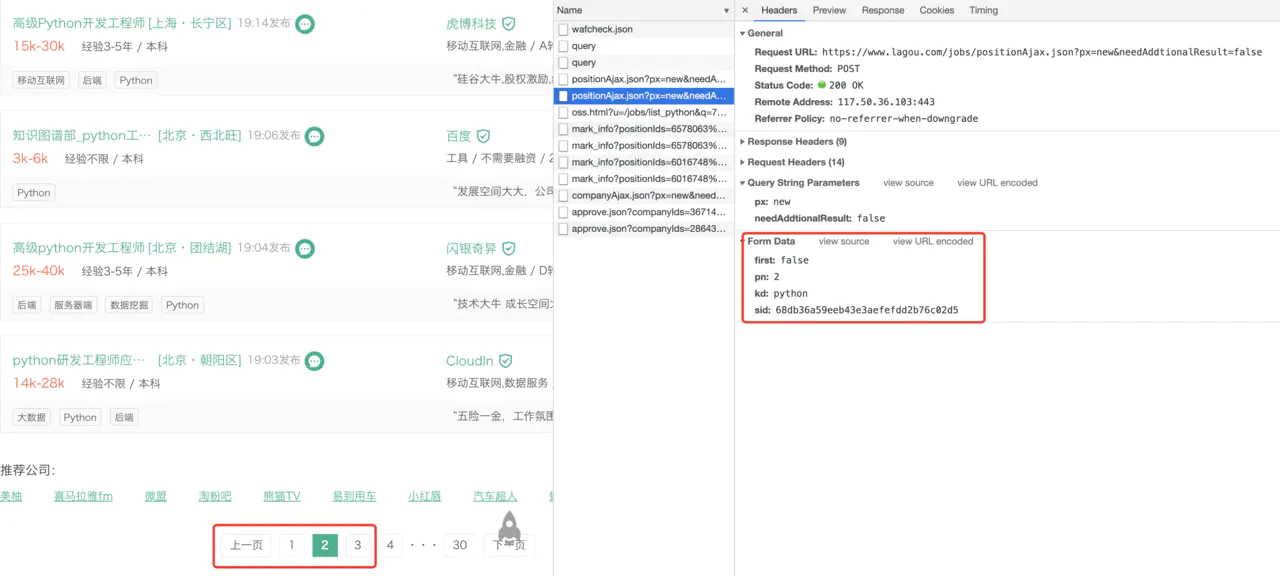

在多次对网页界面进行分析评测的时候,发现在点击第二页的时候Form Data的携带格式发生了变化。可以看到 pn=2 肯定是咱们的当前的页数。

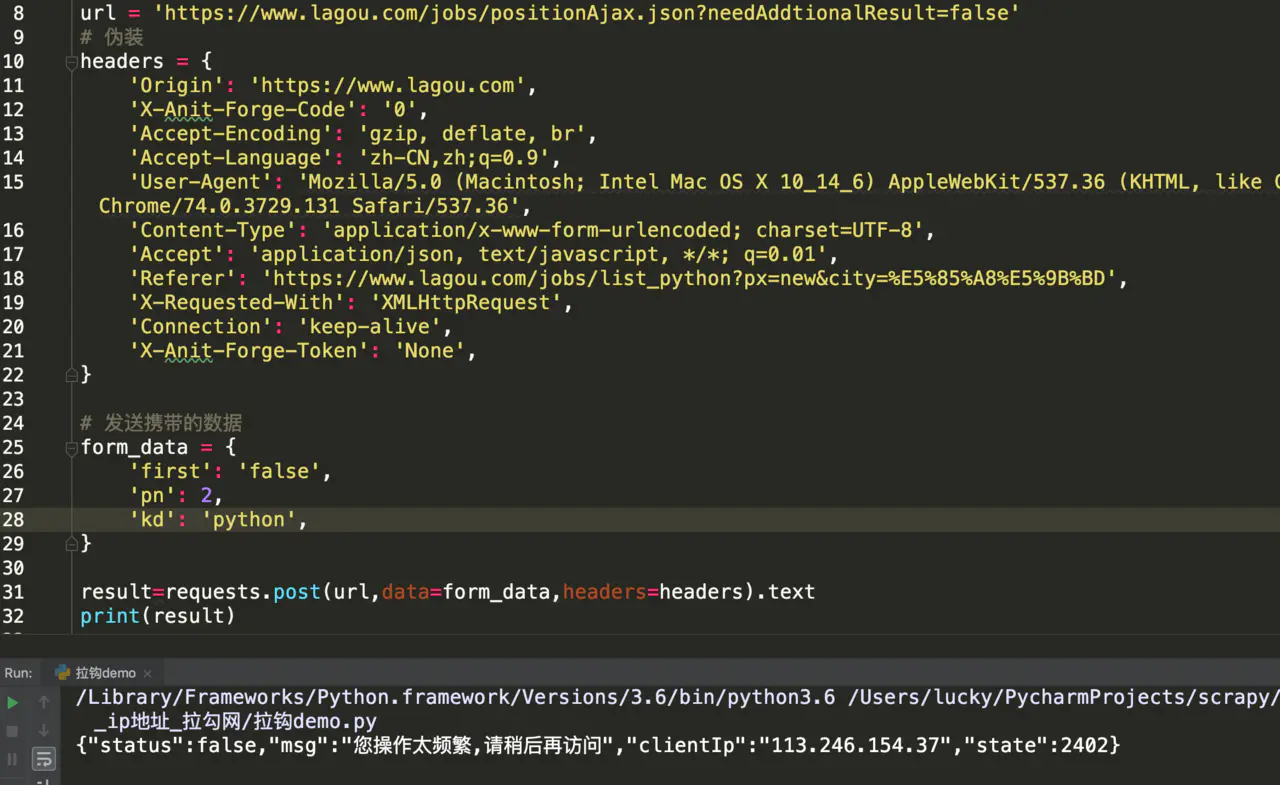

在直接请求界面的时候我们发现网站有反爬机制,不让我们请求《"msg":"您操作太频繁,请稍后再访问"》,我们携带请求头伪装一下,不行

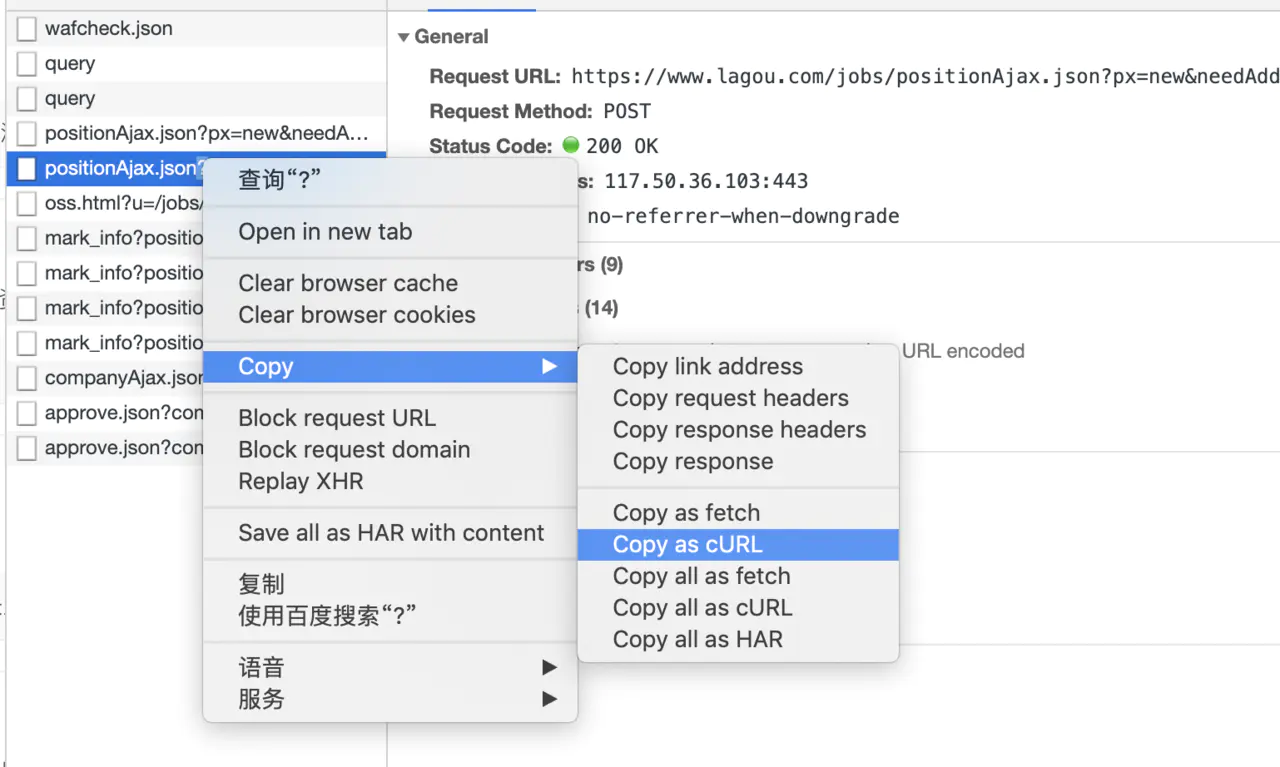

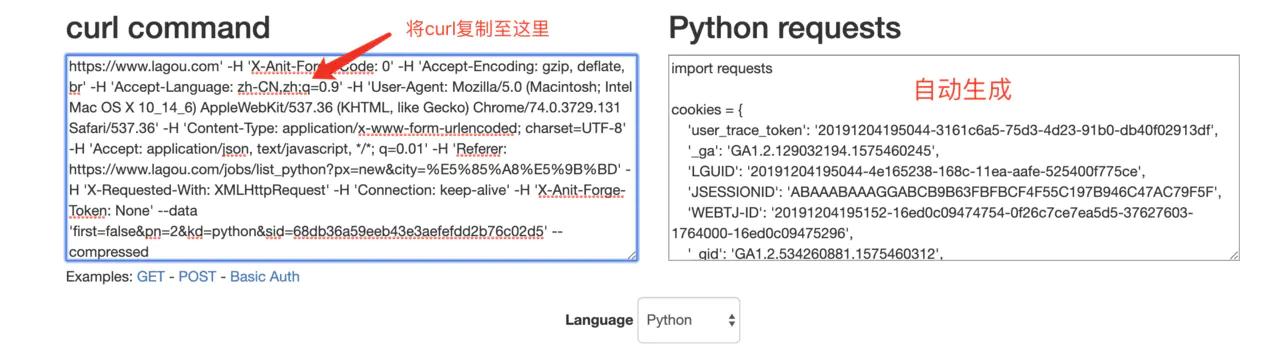

这里我用了一种可以快速生成headers以及cookie的工具:用法如下:

我怀疑该网站具有多重反爬策略,当我再次添加cookies试一下的时候;我们发现数据可以正常获取了;难道就这么简单就解决拉勾网数据获取的问题了吗?然而机智的我察觉到事情并没有想像的那么简单;

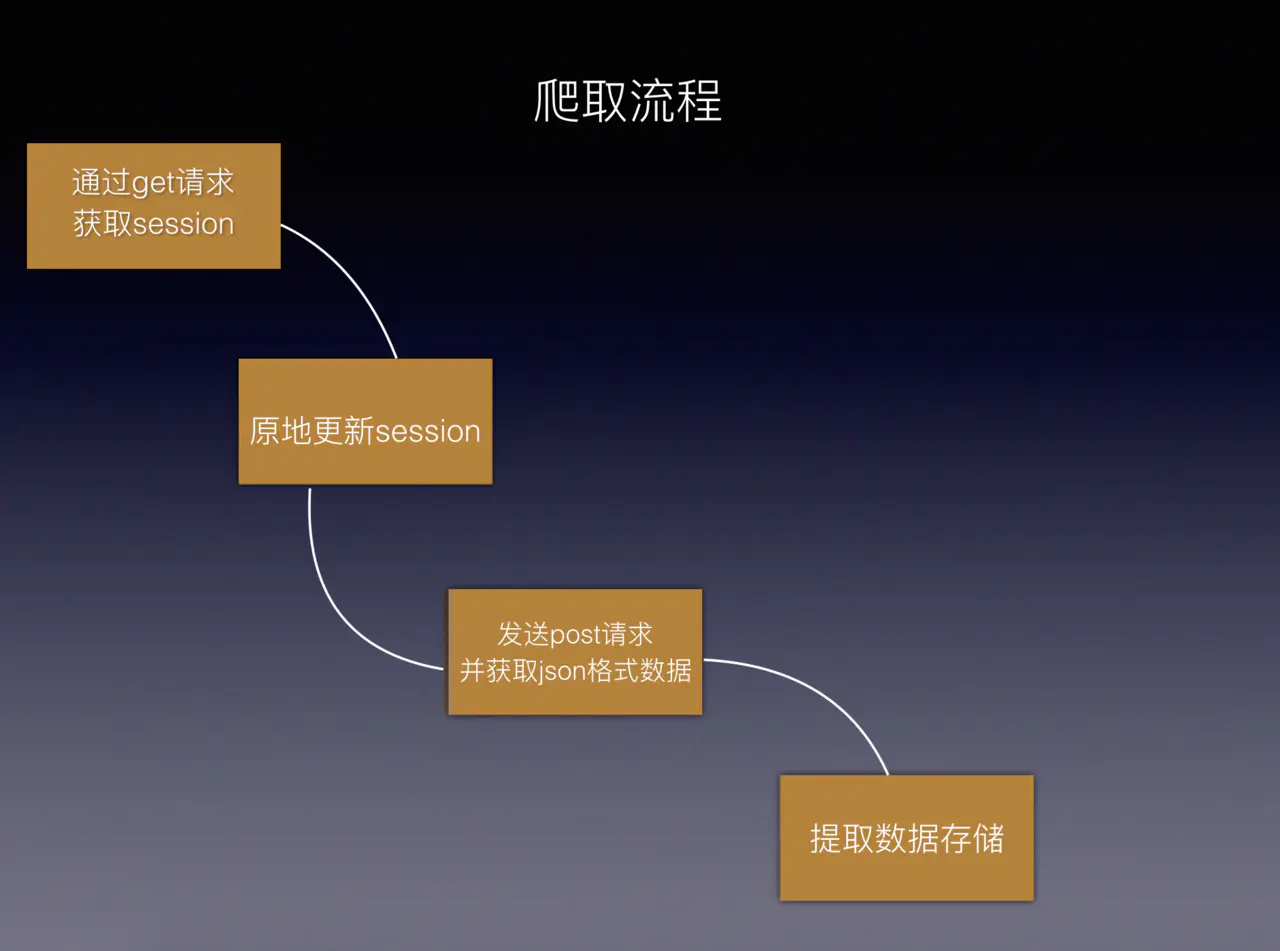

我的最终解决方案是共用 session,就是说我们在每次请求界面的时候先获取session然后原地更新我们的session之后再进行数据的抓取,最后拿到想要的数据。

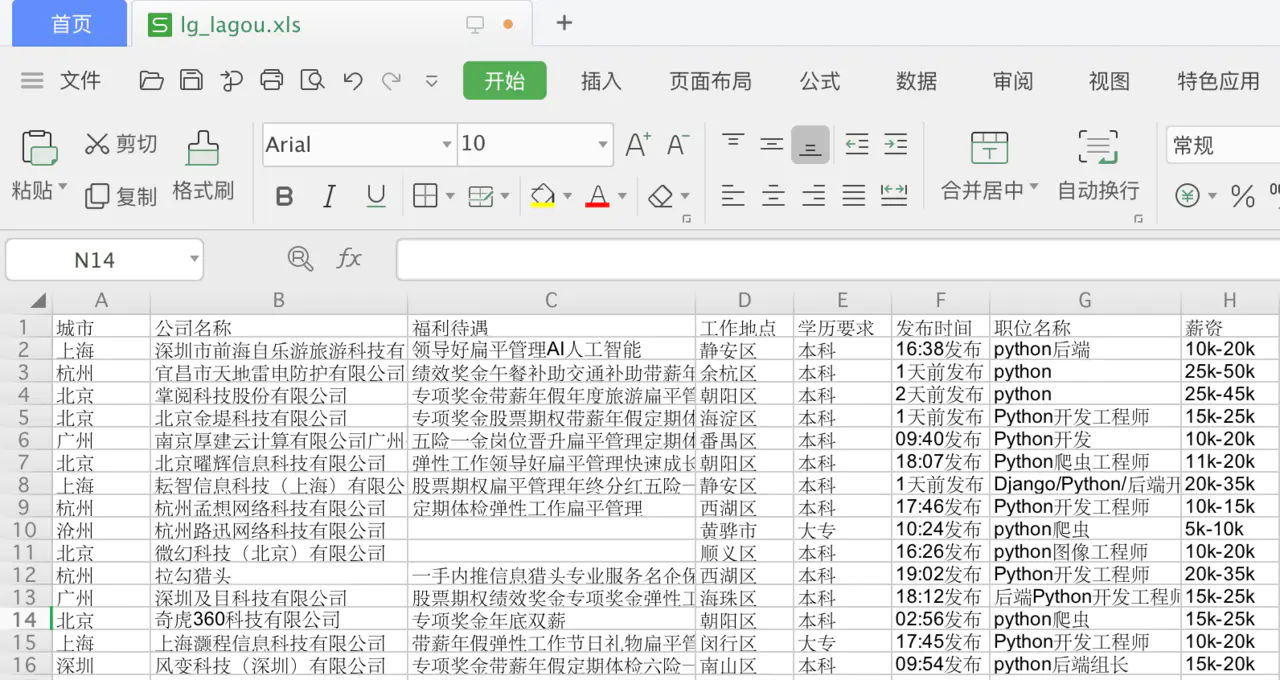

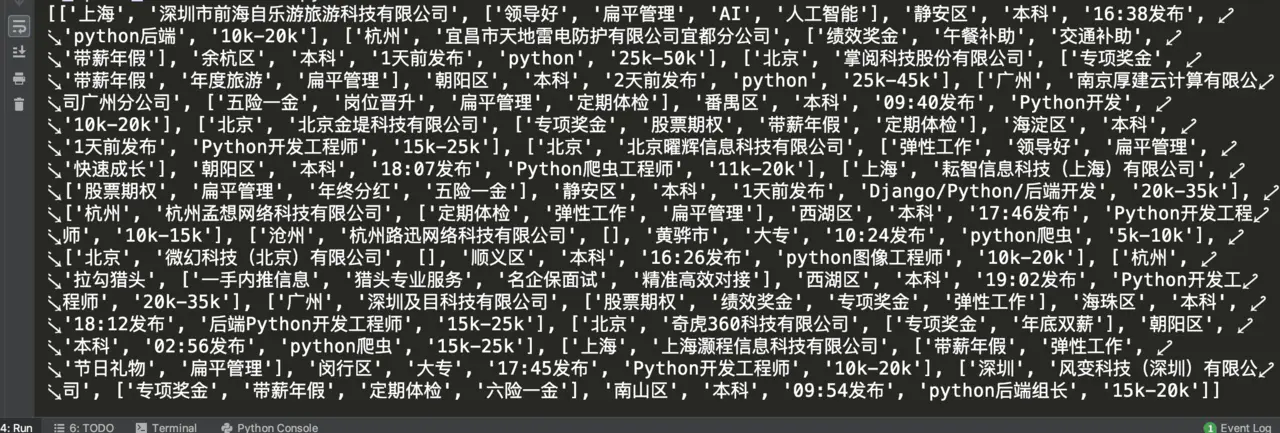

运行结果:

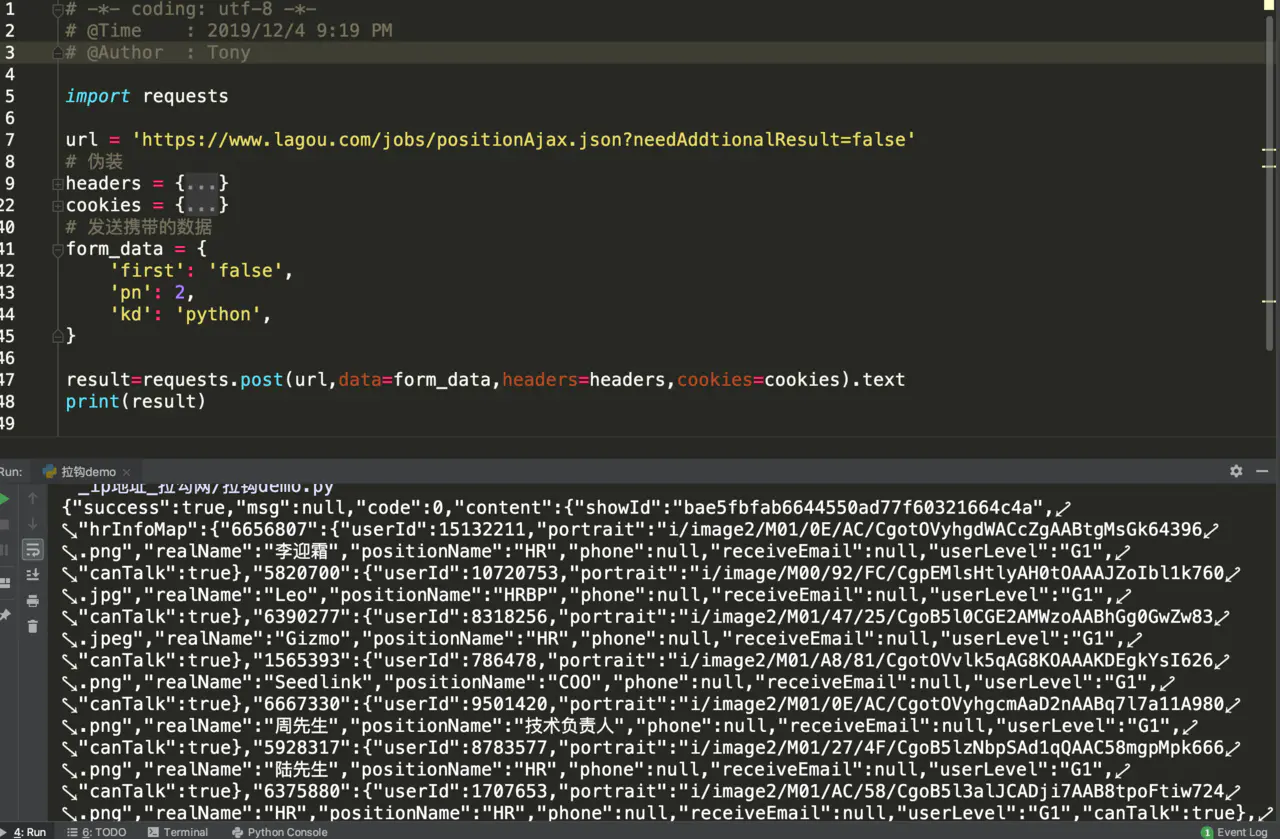

这里通过 excel 表格的形式进行存储;

需要 pip install xlwt 安装一下 xlwt 库.

import xlwt

info_result = []

title = ['城市', '公司名称', '福利待遇', '工作地点', '学历要求', '发布时间', '职位名称', '薪资']

info_result.append(title)

# 获取请求返回数据

info_list=get_requests_data(url, form_data)

# 创建workbook,即excel

workbook = xlwt.Workbook(encoding='utf-8')

worksheet = workbook.add_sheet('lg_lagou', cell_overwrite_ok=True)

# 遍历 枚举

for item, title_data in enumerate(info_list):

for item_data, content_data in enumerate(title_data):

worksheet.write(item, item_data, content_data)

workbook.save('lg_lagou.xls')

复制代码